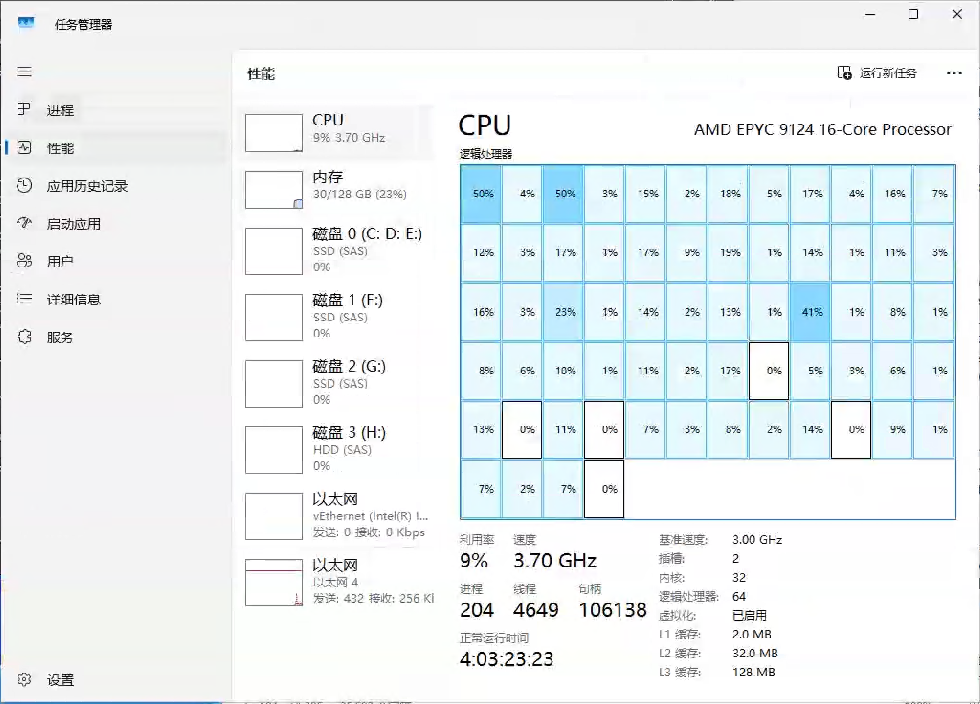

一台H100显卡的服务器,同事们迁移facefusion到H100服务器上,发现无法安装。

系统:Win11

驱动安装:12.4~13均已尝试

无法安装启动,了解后情况后,根据经验应该不是大问题,可以解决。

最后根据一点点的扣各类情况,解决了安装系统的问题。

最后可能是驱动的问题以及驱动之间兼容的问题导致,之前采用的是312版本的py(312也可以搭建安装跑起来),文章用311版本的来操作。

conda activate facefusion_py311 activate facefusion_py311 pip install -r requirements.txt

一下均在环境下执行。

然后安装相关的组件。

思路可以围绕以下几点。 这里没安装更高的版本。

pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu126

安装后命令行进入python

import torch print(torch.__version__) print(torch.version.cuda) print(torch.cuda.is_available())

查看返回结果。如有版本及True

然后驱动需要重新安装一下。将原有的显卡驱动卸载,重新安装 CUDA Toolkit 地址可以参考我上一篇文章 ,安装cuda toolkit这一步很重要,不用安装太高版本。最后会提示是否安装成功。

记得把CUDA Toolkit 的安装路径等添加到环境变量内:(根据自己实际路径情况添加)

C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v12.6\ C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v12.6\bin C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v12.6\libnvvp C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v12.6\

检查onn版本 ,一点要选择onnxruntime-gpu及对应版本,否则会出现下面这两种情况,都是跟兼容有关。

pip show onnxruntime-gpu查看版本,如果不是gpu的也不行

2025-10-11 13:59:20.6235293 [E:onnxruntime:Default, provider_bridge_ort.cc:2251 onnxruntime::TryGetProviderInfo_CUDA] E:\_work\1\s\onnxruntime\core\session\provider_bridge_ort.cc:1844 onnxruntime::ProviderLibrary::Get [ONNXRuntimeError] : 1 : FAIL : Error loading "C:\ProgramData\Anaconda3\envs\facefusion\Lib\site-packages\onnxruntime\capi\onnxruntime_provideN0Rc歔剉!jWW0")ich depends on "cudnn64_9.dll" which is missing. (Error 126: "~b

或者下面

2025-10-11 15:24:02.8528913 [E:onnxruntime:Default, provider_bridge_ort.cc:1992 onnxruntime::TryGetProviderInfo_CUDA] D:\a\_work\1\s\onnxruntime\core\session\provider_bridge_ort.cc:1637 onnxruntime::ProviderLibrary::Get [ONNXRuntimeError] : 1 : FAIL : LoadLibrary failed with error 126 "" when trying to load "C:\ProgramData\Anaconda3\envs\facefusion\Lib\site-packages\onnxruntime\capi\onnxruntime_providers_cuda.dll"

卸载重新安装对应的版本

pip uninstall onnxruntime-gpu -y pip install onnxruntime-gpu==1.19.2 --index-url https://download.pytorch.org/whl/cu129

可以自己尝试。

pip install onnxruntime-gpu==1.19.0 --index-url https://download.pytorch.org/whl/cu126

安装后查看,命令行进入python

import onnxruntime as ort print(ort.get_device())

返回GPU即可

然后可以参考https://docs.facefusion.io/installation/accelerator/windows#cuda

安装自己合适的版本:

conda install nvidia/label/cuda-12.9.1::cuda-runtime nvidia/label/cudnn-9.10.0::cudnn pip install tensorrt==10.12.0.36 --extra-index-url https://pypi.nvidia.com

之后在启动查看,有问题就解决:

python facefusion.py run

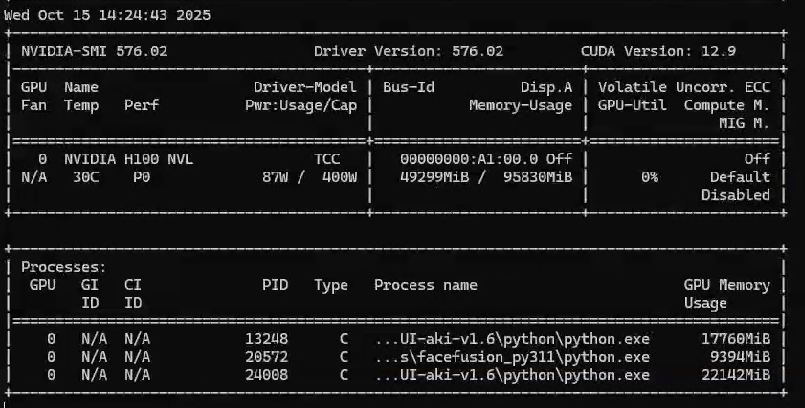

因为任务管理器内无法看到CUDA标签来看GPU的资源调度情况,所以可以通过nvidia-smi来查看

nvidia-smi

ONNX_Runtime其他版本地址,可以参考下面

https://elinux.org/Jetson_Zoo#ONNX_Runtime

如果你觉得好,请大家到公众号给个红心支持一下!!

玩趣儿

玩趣儿

0 条评论。